Hoe je AI veilig gebruikt

Wat zijn de belangrijkste problemen van AI met betrekking tot beveiliging? En hoe kunt u uw organisatie tegen deze risico's beschermen?

> Uw Uitdagingen > Hoe gebruikt u AI veilig?

AI Veilig Gebruiken

Auteur: Ralph Moonen, Technisch Directeur bij Secura/Bureau Veritas

Met de enorme groei in de mogelijkheden van AI, en in het bijzonder Grote Taalmodellen (LLM's), vragen onze klanten steeds vaker om advies over de beveiliging van AI. Is het mogelijk om AI veilig te gebruiken? Wat zijn de belangrijkste beveiligingsproblemen van AI? En hoe kunt u uw organisatie tegen deze risico's beschermen?

Ik denk dat de meeste mensen het erover eens zijn dat het nut van AI, en in het bijzonder LLM's, zodanig is toegenomen dat je ze niet langer kunt negeren. In het bedrijfsleven kunnen ze geweldige productiviteitsverhogers zijn voor tekstgerelateerde taken, zoals vertalingen of samenvattingen.

Voor softwareontwikkeling kunnen AI's ook uitstekende coderings- en debuggingshulp bieden. Zo kunt u bijvoorbeeld ChatGPT of Claude 3 vragen om code te genereren of te helpen bij het debuggen. Het is leuk om creatief te worden en als u wilt zien wat mogelijk is, dan is de thread op https://twitter.com/javilopen/status/1719363262179938401 een geweldig voorbeeld. Een andere manier om AI's in codering te gebruiken, is voor assistentie bij reverse engineering, decompilatie en andere taken. Dit kan krachtig zijn bij het uitvogelen van de functionaliteit van bepaalde code.

Hallucinatie en auteursrechtproblemen

Natuurlijk hebben AI's de neiging om te hallucineren: controleer en valideer alle output, anders zou u codeconstructies of commandoregels kunnen gebruiken die geen basis in de realiteit hebben. Ook heeft output van publieke en generatieve AI's geen auteursrecht: u kunt het gebruiken zoals u wilt (inclusief afbeeldingen, teksten, broncode en software). Maar u kunt geen eigen auteursrecht claimen, dus het verkopen of gebruiken in producten kan problematisch zijn. Dit zijn algemene risico's die u tegenkomt bij het gebruik van AI.

De twee belangrijkste beveiligingsrisico's van AI

Er zijn ook meer specifieke beveiligingsrisico's verbonden aan het gebruik van AI.

Risico 1: Het lekken van informatie

Het eerste beveiligingsrisico bij het gebruik van AI is dat alles wat u uploadt of kopieert en plakt in een AI in wezen betekent dat u die informatie lekt. Ongeacht de functies, schakelaars of configuraties van het AI-model, als u gevoelige informatie naar een derde partij uploadt, is het gelekt.

En u moet zich ervan bewust zijn dat alles wat in een AI gaat, er ook uit kan komen. Het kan wat aansporing nodig hebben om 'de boel te verraden', maar het is mogelijk geweest om modellen, trainingsgegevens en andere gebruikersprompts te extraheren. Een onderzoeker aan de Northwestern University testte meer dan 200 aangepaste GPT's en slaagde erin om informatie uit 97% van deze te halen met alleen eenvoudige prompts. Dus niet alleen de AI-operatoren hebben inzicht in wat u hebt geüpload: tegenstanders kunnen ook trainingsgegevens uit AI's extraheren door middel van promptinteractie.

Dit betekent dat het vragen van een AI om een tekst met bedrijfsgeheimen of gevoelige persoonlijke informatie samen te vatten geen goed idee is, zelfs niet wanneer versterkt leren niet is ingeschakeld. Voer de AI alleen informatie die niet gevoelig is, zoals commerciële teksten, website-inhoud of openbaar beschikbare informatie. Natuurlijk kan een mogelijke oplossing hiervoor zijn om uw eigen LLM in uw privécloud of on-premise uit te voeren. Hoewel dit

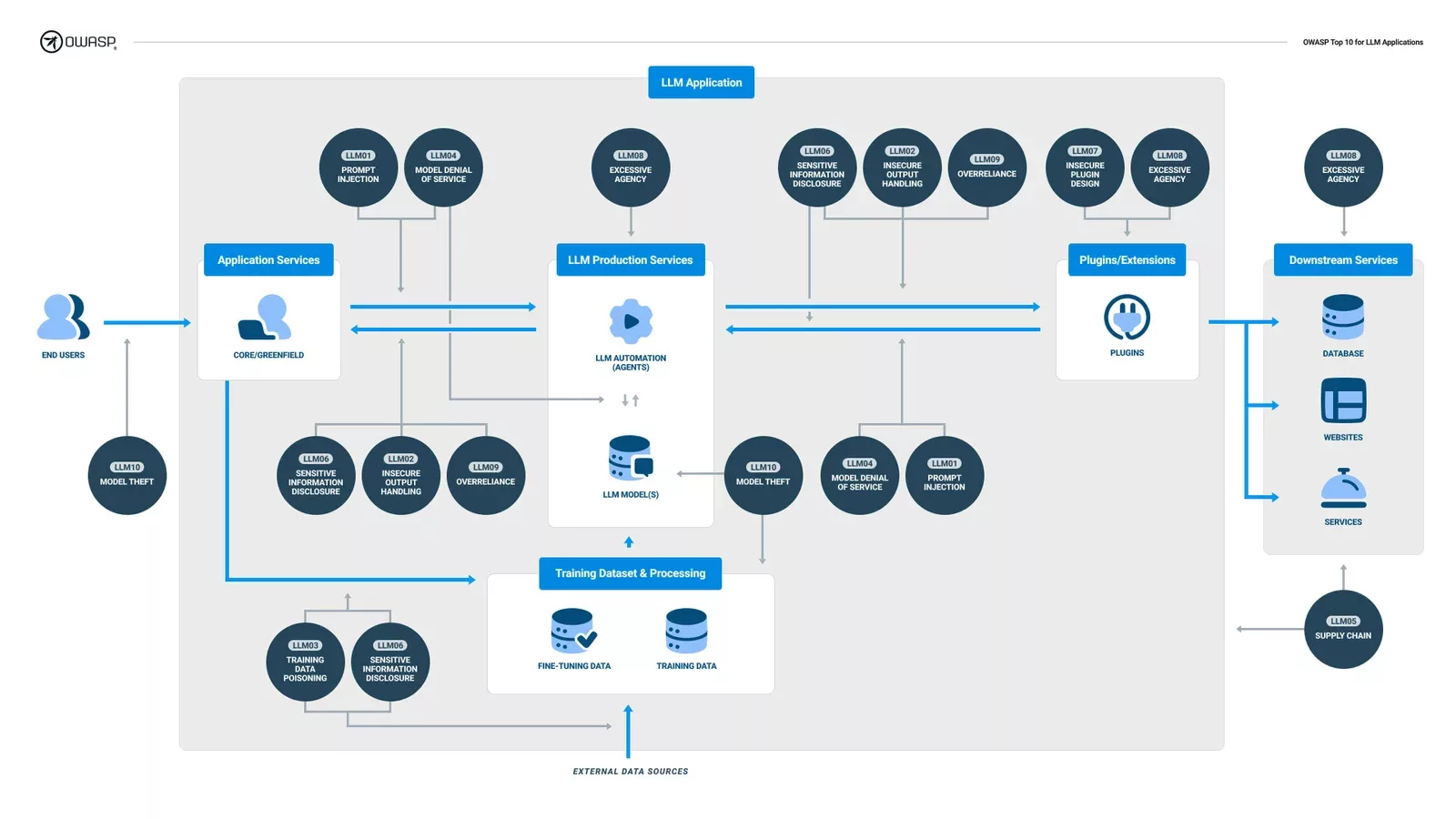

De OWASP Top 10 for LLM's. Bron: LLMTop10.com

Als u meer wilt weten over deze soorten aanvalstechnieken, heeft OWASP een geweldige bron op https://owaspai.org/ en natuurlijk is er al een OWASP Top10 voor LLM's: https://llmtop10.com/.

De risico's beveiligen

Hoe kunt u de risico's beheersen bij het gebruik van AI's? In termen van beveiligingsmaatregelen, zou u moeten overwegen om een Acceptabel Gebruiksbeleid voor AI's op te stellen. En u wilt misschien ook overwegen om een AI-register samen te stellen waarin staat waar AI's in uw organisatie worden gebruikt en voor welke taken. Dit zal helpen om richtlijnen te bieden aan uw collega's en hen bewust te maken van de risico's. Alternatief kan het nodig zijn om on-premise AI's te overwegen, en gelukkig zijn er LLM's en andere modellen die dit toelaten (hoewel de benodigde computerbronnen vaak niet triviaal zijn). En natuurlijk: testen, testen, testen.

AI-beveiliging testen

We ontvangen nogal wat vragen van klanten over AI-beveiliging. Hoewel het voor ons relatief nieuw is (zoals voor iedereen), ontwikkelen we capaciteiten op dit gebied. We kunnen basis AI-beveiligingstests uitvoeren, waarbij we de robuustheid en veerkracht van de LLM tegen aanvallen zoals modelextractie, promptinjectie, AI-manipulatie, modelvervuiling, hergebruik of lidmaatschapsinferentie kunnen testen.

Ten slotte, als u vragen heeft over AI-beveiliging, neem dan contact op met uw Account Manager of stuur een e-mail naar info@secura.com.

De cybersecuritywereld verandert. Abonneer u op onze Cyber Vision Nieuwsbrief op LinkedIn om meer te leren over de veranderende aard van cybersecurity en de toekomst van cyberveerkracht.

Over de auteur

Ralph Moonen, Technical Director at Secura/Bureau Veritas

Ralph Moonen is Technisch Directeur bij Secura/Bureau Veritas.

Hij is een specialist in informatiebeveiliging met meer dan 20 jaar ervaring in het werken met grote (Fortune 500, overheden, financiële instellingen, internationale organisaties enz.) klanten in nationale en internationale context.

Docent bij de postdoctorale cursus IT-auditing aan de Universiteit van Tilburg.

Waarom kiezen voor Secura | Bureau Veritas

Het doel van Secura/Bureau Veritas is om uw vertrouwde partner in cybersecurity te zijn. Wij gaan verder dan snelle oplossingen en geïsoleerde diensten. Onze geïntegreerde aanpak zorgt ervoor dat elk aspect van uw bedrijf of organisatie cyberweerbaar is, van uw technologie tot uw processen en uw mensen.

Secura is de cybersecuritydivisie van Bureau Veritas, gespecialiseerd in testing, inspection en certification. Bureau Veritas werd opgericht in 1828, heeft meer dan 80.000 werknemers en is actief in 140 landen.